Avec Genie 3, Google DeepMind transforme les « world models » en simulateurs 3D jouables en temps réel

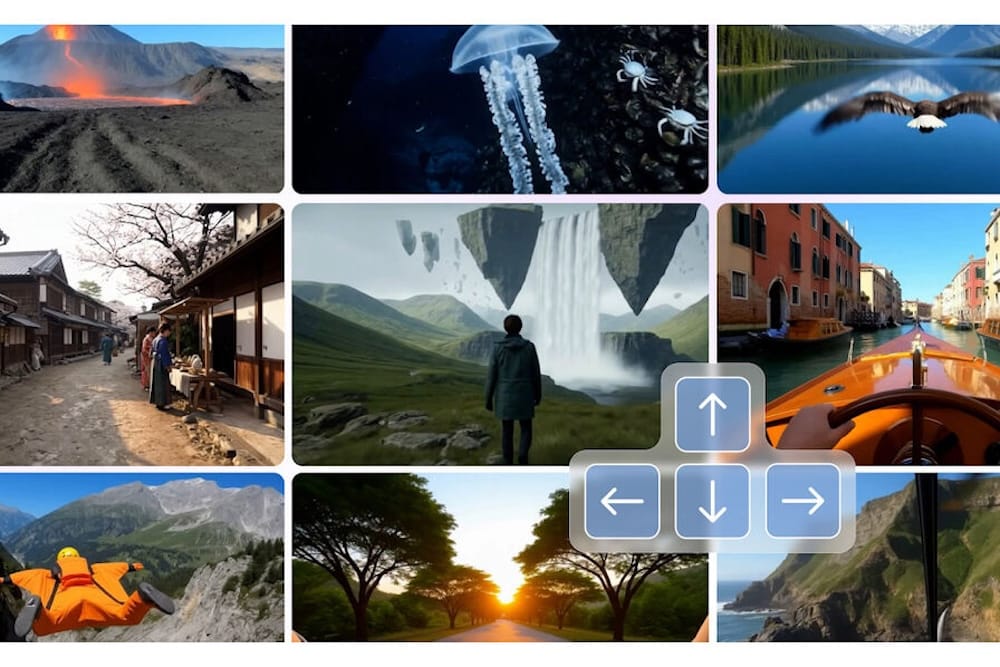

Le 5 août 2025, Google DeepMind a dévoilé Genie 3, un nouveau « world model » capable de générer à la volée des environnements 3D interactifs, explorables en temps réel à 24 ips et en 720p, avec une cohérence maintenue pendant plusieurs minutes. L’ambition est claire : doter l’IA de terrains d’entraînement riches et variés, sans passer par des moteurs classiques ni des pipelines de modélisation coûteux.

Ce que Genie 3 change

Genie 3 franchit deux caps simultanés : l’interactivité native (on se déplace dans le monde généré comme dans un « jeu »), et l’allongement de l’horizon temporel, avec une « mémoire visuelle » qui peut remonter jusqu’à environ une minute. Concrètement, des objets laissés hors champ réapparaissent là où on les a quittés ; la scène ne « s’effondre » plus au bout de quelques secondes comme sur les itérations précédentes.

DeepMind met aussi en avant les « événements promptables » : au-delà des commandes de navigation, des instructions textuelles modifient l’état du monde (changement de météo, apparition de personnages ou d’objets), sans recharger la scène. C’est un pas vers des scénarios contrefactuels qui permettront de tester des comportements en conditions inhabituelles.

Pourquoi ce n’est pas (seulement) pour le jeu vidéo

Si la démonstration évoque un moteur de jeu neuronal, l’objectif prioritaire n’est pas le divertissement : Genie 3 sert de banc d’essai pour les agents incarnés, y compris en robotique. DeepMind montre ainsi l’intégration avec SIMA, son agent généraliste pour environnements 3D : dans des mondes générés par Genie 3, l’agent enchaîne des séquences d’actions plus longues, donc plus utiles pour l’apprentissage par interaction.

L’intérêt est évident pour entraîner des IA à des tâches risquées ou rares dans le monde réel (conduite autonome, interventions industrielles, secours, etc.). La génération « à la demande » d’environnements variés ouvre la voie à des curriculums quasi illimités, un pré-requis revendiqué sur la route de l’AGI.

Les limites à court terme

DeepMind souligne plusieurs verrous :

- Espace d’actions restreint pour l’agent (les « événements » déclenchés par texte ne sont pas forcément exécutés par l’agent lui-même) ;

- Interactions multi-agents encore difficiles à simuler de façon crédible ;

- Durées continues limitées à quelques minutes ;

- Géographie imparfaite (reproduire fidèlement un lieu réel reste hors de portée) ;

- Lisibilité du texte à l’écran inégale sans consigne explicite.

Côté disponibilité, Genie 3 n’est pas public : DeepMind en propose un aperçu de recherche limité à un petit groupe d’académiques et de créateurs, afin de recueillir des retours et d’évaluer les risques.

Mise en perspective

L’an passé, Genie 2 avait posé les bases : des mondes 3D jouables à partir d’une image de départ, mais sur des durées courtes et avec moins de stabilité. La vraie nouveauté de Genie 3 est de combiner jouabilité en temps réel, cohérence sur plusieurs minutes et édition du monde par texte, trois propriétés rarement réunies dans un modèle unique.

Enjeux pour l’écosystème IA

Pour les équipes data/robotique, Genie 3 esquisse un pipeline de simulation plus agile : moins de dépendance à la capture/scan 3D ou au level design manuel, plus de variabilité et de contrôle sémantique via le langage. À l’inverse, la facture calcul et la latence resteront des facteurs déterminants pour un usage à grande échelle, notamment si l’on vise des sessions d’entraînement longues et des environnements denses.

Verdict : Genie 3 est un jalon crédible vers des simulateurs génératifs généralistes. Il ne remplace pas encore les moteurs temps réel traditionnels pour des productions interactives complexes, mais accélère la recherche sur les agents — y compris humanoïdes — en offrant un terrain d’expérimentation rapide, contrôlable et riche.